Quiero aclarar desde el principio que no tengo ningún dato que me permita valorar si existe plagio (o comportamientos deshonestos) en la comunidad académica a la que presto mis servicios. Antes de valorar si esa falta de información me debe preocupar, voy a repasar, en calidad de profesor e investigador de universidad publica española, en qué aspectos me preocupa el plagio, qué necesidades de control detecto y cuáles serían sus requerimientos.

Para ello, tendré en cuenta los diferentes roles que desempeño en mi universidad. Soy profesor en varias asignaturas de grado o máster y tutor de trabajos final de grado o máster; Subdirector de Investigación del DOE y, por lo tanto, validador de los méritos científicos de las personas pertenecientes a esta estructura; Director Académico de los Títulos GIOI y MUGESP; miembro de la Comisión Académica del Titulo del Programa de Doctorado en Administración y Dirección de Empresas y editor jefe de la revista científica WPOM.

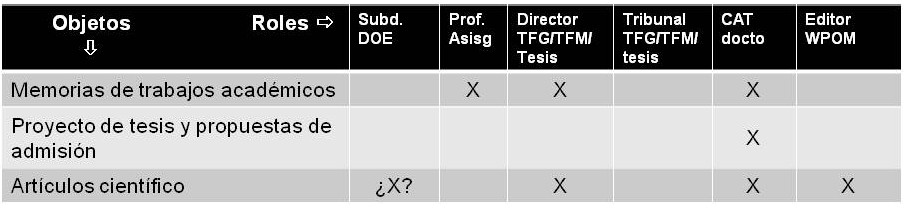

En la tabla siguiente relaciono los diferentes objetos, que me preocupan que puedan ser plagiados, con el rol que desempeño cuando los valoro.

Como punto de partida, creo que se necesitan dos cosas para acabar con el plagio o la deshonestidad académica: sensibilizara a alumnos/profesores sobre honestidad académica y tener un buen sistema antiplagio para detectar si alguien no se sensibiliza.

En el caso de memorias de trabajos académicos o preguntas de desarrollo me centraré en las que los alumnos entregan como documento electrónico, bien sobre plataformas on-line en situación de examen o en trabajo autónomo. Por ello descarto el poder detectar el plagio cuando entregan el trabajo escrito a “mano” (lo que tendría cierta implicación a la hora de reflexionar sobre las situaciones ideales para realizar un examen si quiero evitar el plagio). Lo que me preocupa en este caso es tener la seguridad de que los trabajos que me presentan mis alumnos son fruto de su trabajo y de su aprendizaje y no algo que se hayan “descargado” o “copiado y pegado” de documentos realizados por otras personas. Esto sería extensible a las propuestas de proyectos de tesis o a la propuesta de solicitud para acceder a un doctorado.

Para ello, considero imprescindible disponer de una herramienta admita documentos en texto plano, RTF, PDF o en alguno de los formatos de procesador de texto habituales. Que detecte plagio, no sólo entre los trabajos de sus compañeros de curso, sino también de trabajos de otros años o de otras universidades/titulaciones, o de documentos accesibles en páginas web o de foros que requieran un login y password para acceder a los “servicios” y, por si fuera poco, que detecte fuentes en otros idiomas (es decir, el mismo texto en castellano, valenciano o inglés, como mínimo, pues los tres son idiomas oficiales de mis asignaturas).

Hasta el momento sólo he tenido la oportunidad de probar algunas herramientas gratis en internet, la versión gratuita de VIPER y la versión piloto de una herramienta de desarrollo local en la UPV (DOCODE).

Lo que he visto hasta el momento -ultima prueba en septiembre de 2014- no puede ser más inútil y más desalentador (por no poner adjetivos más negativos). Las plataformas web gratuitas son incómodas de manejar (hay que subir los textos uno a uno), muchas veces sólo admiten texto plano, no se puede subir un archivo, y limitan el número de palabras que permiten por “documento” o en todos los documentos revisados en un plazo de tiempo. Estos límites varían pero pocas veces permiten analizar un documento completo (solo unos pocos párrafos o páginas). Por otra parte, casi nunca detectan plagio (yo lo he probado subiendo una copia de textos que existen en internet con acceso público y no los detectan).

VIPER , en su versión gratuita 4.1.9, aparentemente supera alguno de estos problemas (al menos la de subir ficheros y varios de golpe), pero tiene una limitación de número de palabras por día. Además, el programa es bastante inestable, no permite subir documentos PDF (diga lo que diga su propaganda) y muy lento. Por otra parte los resultados no han resultado nada satisfactorios (son mejores que las páginas web o que DOCODE, pero insuficientes, por lo menos en la versión gratuita). Por ejemplo, tras descargar una página de wikipedia traducida en google translator, me ha detectado 3 fuentes de Scribd y otros servicios de trabajos de alumnos, pero no me ha detectado la fuente original. Además el programa no funciona bien con textos en castellano o textos que no estén codificados UTF-8 pues todas la tiles, “ñ” etc rompen la cadena de detección dejando unos porcentajes de similitud entre el 15% y el 22% cuando en realidad es exactamente el mismo texto.

El programa DOCODE lo he probado con más detenimiento subiendo una batería de textos y los resultados son incluso peores que VIPER gratuito. He puesto un documento y su traducción al ingles y no detecta que son lo mismo (por lo tanto no me protege en absoluto contra el plagio entre idiomas oficiales en mis asignaturas: castellano, valenciano y en muchas ocasiones inglés, ni frente a traducciones de trabajos que localicen en la web). He descargado unos PDF de la web, los he metido en escalona y me salen solo parcialmente referenciados en la web cuando son una copia exacta en el mismo idioma. En otra prueba he descargado un documento del ministerio y otro de un repositorio, y las fuentes web que me cita son “wikipedia” cuando hace la definición de una de las frases en el contenido, en lugar de identificarme el documento que me he descargado de una web pública sólo 3 minutos antes. He subido un PDF de un documento que está en un repositorio abierto en internet y no lo detecta como plagio. Por último, he metido dos TFG casi iguales, son dos versiones con mínimos cambios de un mismo alumno… y no me dice que son lo mismo.

No he tenido la posibilidad de probar Turnitin (y no se si es merecedor de la fama que tiene como el “mejor” sistema detector de plagio). Lo que si he podido comprobar es que Trunitin es Caro, pero siempre me asalta la duda de si desarrollar algo que se parezca a Turnitin no será más caro todavía (y con el riesgo adicional que nos salga un producto que no resuelve nuestras necesidades). Por otra parte, en cosas como estas, dudo que un desarrollo local sirva de verdad para algo… Si no somos capaces de desarrollar un sistema que comparta mucha gente (la mayoría de las universidades de habla castellana: españolas y latinoamericanas, públicas y privadas…) esto será un coladero. Si lo compartimos muchos, el coste será mucho menor (para mi esto debería ser un proyecto de software libre pagado por varias universidades o vía crowsourcing, para que realmente acabe siendo algo que se acerque o mejore a Turnitin). Hay experiencias de software desarrollado de esta manera (el que más lo necesita tira del carro y poco a poco se van enganchando otros que acaban aportando recursos o dinero para el desarrollo. Moodle, Limesurvey, Trello, son ejemplos de plataformas que se han creado así). Siendo algo que todas las universidades necesitan, supongo que habría masa suficiente para que aportando todos un poco, el proyecto vaya adelante… pero si en lugar de eso cada una opta por gastarse “su” dinero para crear “su” aplicación, al final no creo que logremos lo que se necesita y entre todos habremos gastado una fortuna para nada. Si no somos capaces de “pactar” un proyecto común (open) para algo que necesitamos y que, “necesariamente”, tenemos que parir entre todos para que sea útil y no deje resquicios al plagio entre universidades, creo que ya hemos perdido la batalla antes de comenzarla.

Y se trata de una batalla, desde mi punto de vista, importante. ¿Para qué me voy a esforzar como profesor en gastar mi tiempo en evaluar de manera fiable y justa unos trabajos, si no puedo tener la garantía de que el alumno que lo presenta es el autor del trabajo? Lo que ocurre es que, en estos momentos, no tengo ninguna herramienta para poder estimar si el plagio es un problema grave o no en mi contexto. ¿Hay mucho o pocos alumnos que plagian sus trabajos? Ni idea. Y no tengo forma de saberlo si mi institución no me proporciona unas herramientas adecuadas. Quizás habría que elegir una muestra de asignaturas y TFG/TFM, usar una plataforma fiable para analizar si hay plagio en los trabajos que han presentado los alumnos en los últimos dos años (cueste lo que cueste no será caro porque estamos hablando de una muestra), y extrapolar los resultados para estimar si se trata de un problema grave o no.

Por otra parte, este problema no reside solo en grado… en posgrado y doctorandos parece que el problema también puede ser importante ( PH.D. IN “COPY-AND-PASTE”? Addressing the Rise of Plagiarism in Graduate Programs ). No obstante, de nuevo habría que valorarlo, porque los autores de este informe son parte interesada en demostrar que el plagio es grave porque venden sistemas antiplagio.

También quiero aprovechar para reflexionar sobre el plagio de artículos científicos por dos motivos. Uno, es que en el máster y en el programa de doctorado donde participo, los alumnos pueden presentar su TFM o su tesis en dos formatos. Pueden hacer una monografía (en cuyo caso la detección de plagio seguiría un procedimiento similar al de los trabajos académicos que ya he comentado) pero también pueden presentar una colección de artículos. En estos casos, se necesita un sistema especializado en detección de plagio de artículos científicos. Por otra parte soy editor de una revista científica y cada vez que se sube un artículo a la plataforma debería poder comprobar si es original o una copia de algo que ya se ha publicado. Y esto debería hacerlo antes de mandar el artículo a los revisores de la revista. Para que solo gasten su tiempo en aportaciones originales.

Por suerte, el mercado tiene una plataforma muy buena y probada para la detección de plagio iThenticate: Plagiarism Detection Software. Pero, por desgracia, vuelve a ser cara (al menos para los presupuestos disponibles en el programa de doctorado, prácticamente cero, o en una revista OPEN JOURNAL que no tiene fuentes de ingresos). En este caso hemos podido contar con el apoyo de la editorial UPV para poder aplicar este sistema a los artículos remitidos a la revista a partir de 2015, lo que es algo muy de agradecer.

Visitas: 58