Estoy embarcado en una investigación (Action Research) sobre barreras y facilitadores para la investigación (innovación) sobre aprendizaje, por parte del personal docente e investigador (PDI) de universidades españolas. Es decir, cosas que ayudan o frenan a que los PDI investiguemos sobre la docencia/aprendizaje en nuestras asignaturas.

El origen de esta investigación es la constatación de que los PDI «no pedagogos» apenas publicamos los resultados de nuestra investigación sobre aprendizaje (Marin, 2018). Lo que me hace sospechar que, en el fondo, ni investigamos, ni reflexionamos, ni innovamos en este aspecto. Esta sospecha está alentada porque casi nunca oigo hablar a mis «compañeros“ de la docencia basada en evidencia (o el scholarship, que podría ser un sinónimo). La docencia basada en evidencia (EB-learning) se basa en investigar sobre cómo aprenden nuestros alumnos nuestras asignaturas y publicar en revistas ( o difundir por otros medios) los resultados de dichas investigaciones.

Es posible que haya PDI que no investiguen sobre aprendizaje porque no tienen ninguna duda de como abordar/enfocar su docencia en ningún momento, ni en ninguna de sus asignaturas: tienen muy claro qué objetivos de aprendizaje busca; y qué contenidos/ desarrollo de habilidades y actitudes pretende en sus alumnos, qué secuencia, qué métodos de impartición y de evaluación y qué recursos son los más adecuados para que los alumnos alcancen esos objetivos. Y cuando las cosas cambian -planes de estudio, aulas, madurez de los alumnos….- no tienen ningún problema en encontrar el nuevo ajuste en todas esas variables. Asumo con cierta envida (sana, si existe la envidia de ese tipo), que son seres afortunados y entiendo que no investiguen en algo que no les aporta ningún valor.

Otros PDI pueden considerar que la docencia no es relevante/importante porque son INVESTIGADORES y cualquier otra cosa es quitar tiempo a su importante función de investigar. Tampoco me veo representado en este colectivo.

Yo creo que los PDI de universidades públicas españolas somos esencialmente docentes. O si lo preferís, entre un 50% y un 100% de nuestro tiempo se espera que seamos unos docentes dignos (en esta entrada del blog planteo algunos escenarios sobre esto y en esta otra lo matizo). No me atrevo a decir lo que deben ser los PDI de otros países o de universidades privadas. Pero considerando que los presupuestos de la universidad (al menos la mia) llegan en un 90% por alumnos matriculados; y que según “decreto Wert” (a falta de un estatuto del PDI claro en estas cuestiones), nos pagan por 1.700 horas/año que son equivalentes a 32 ECTS-docentes (un sexenio activo lo equiparan a 8 ects-docentes y 3 (ó 4) sexenios a 16 ECTS-docentes). Por lo tanto, la investigación (toda la actividad investigadora, tanto docente y del área) puede llegar a suponer entre un 25% y un 50% de nuestra paga/dedicación, dependiendo del numero de sexenios ACTIVOS y nuestra categoría profesional (CU o «no CU»).

Resumiendo,yo me considero un docente (al menos el 66% de mi tiempo remunerado) y tengo dudas sobre muchos aspectos de mi docencia; y creo que investigar sobre ello me convertiría en un mejor profesional. Además considero que esto es extensible a todas las personas que comparten mi profesión. De modo que hay cosas que me interesa analizar.

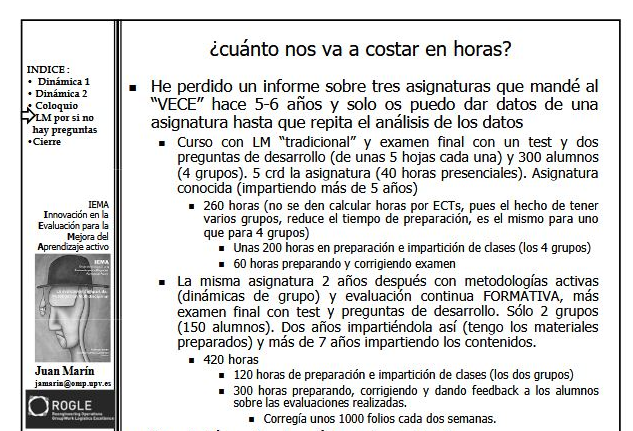

Lo primero que he hecho es intentar conocer donde invertimos nuestro tiempo. De momento tengo unos datos que no son generalizables, porque la muestra es muy pequeña y de conveniencia (33 profesores del área de conocimiento de «organización de empresas»). La imagen muestra estos resultados preliminares que confirman que no se dedica mucho tiempo a investigar en docencia/aprendizaje o en innovar en este tema. Aunque se percibe como una actividad de importancia moderada-alta.

Mi siguiente paso (estoy en ello) es identificar las barreras y facilitadores y escribir un artículo sobre el tema (os iré informando).

Referencias

- Marin-Garcia, J. A. (2018). What are the research focuses regarding learning in the field of operations management in higher education? The case of spain in 2017. Journal of Industrial Engineering and Management, 11(4), 607-616. doi:http://dx.doi.org/10.3926/jiem.2550

- Ramio, C. (2014). Manua para los atribulados profesores universitarios. Madrid: CATARATA.

Visitas: 11