Me gustaría empezar por recordar algo que es obvio, pero que a veces se nos olvida. El objetivo básico de un TFG, desde el punto de vista práctico es aprobar su defensa. Obviamente puede y debe haber otras motivaciones: hacer algo útil para una organización, aprender o reforzar conocimientos o habilidades útiles para tu futuro profesional, etc. Pero lograr todas esas cosas no deben impedir que superes el objetivo básico.

Por ello, la primero que tienes que hacer es revisar cómo te van a evaluar (cuáles son los niveles de desempeño por debajo de los cuales vas a tener problemas el día de la defensa). En estos enlaces tienes las rúbricas y algunas “normas de estilo” para las dos titulaciones de la ETSII en las que suelo participar dirigiendo TFGs. Revisa la que te corresponda, porque es responsabilidad tuya lograr superar cada uno de los criterios (si, cada uno). Las personas que dirigimos el trabajo te podemos aclarar el significado de cada criterio o cada nivel, o decirte en qué nivel vemos que está tu trabajo, o hacerte recomendaciones sobre como pasar de un nivel a otro. Pero, en esencia, la responsabilidad y la iniciativa está en tu parte:

Estos vídeos explican la rúbrica de GIOI:

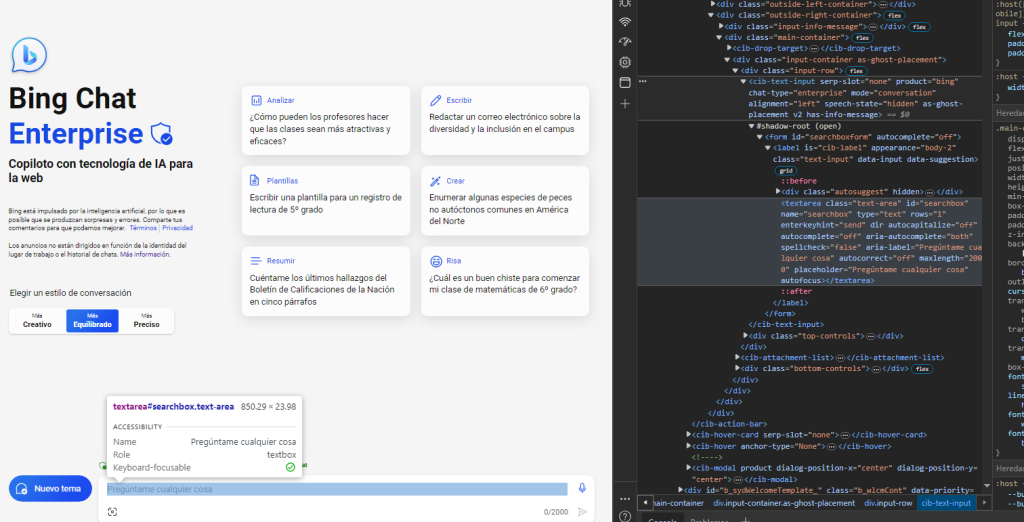

Además, lee estas referencias. Te resultarán útiles porque te resumen algunas recomendaciones sobre como enfocar tu TFG/TFM y también consejos sobre como escribirlo (recuerda citarlas en el documento final)

- Tienes información adicional en esta otra entrada de blog: https://jamg.blogs.upv.es/2024/06/20/3869/(abre en una nueva pestaña)

- García-Sabater, J.P., Como estructurar y escribir un Proyecto Fin de Carrera, Trabajo Fin de Grado o una Tesina Fin de Master. on line. Available at: http://jpgarcia.webs.upv.es/?page_id=34 [Accessed February 5, 2018].

- Garcia-Sabater, J.P., 2014. Consejos para la escritura de proyectos, tesis y trabajos de investigación. riunet UPV, p.8. Available at: http://riunet.upv.es/bitstream/handle/10251/18355/Consejos de Escriturav6.pdf?sequence=1&isAllowed=y [Accessed February 5, 2018].

- http://jpgarcia.webs.upv.es/?page_id=2741

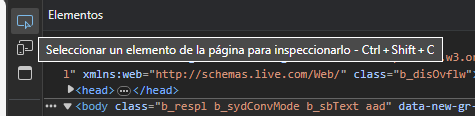

- Esto te puede resultar interesante para preprar la presentación si tienes que defenderla en remoto (por video conferencia) https://ito-engineering.screenstepslive.com/s/ito_fase/m/94256/l/1243152-how-can-i-view-a-powerpoint-show-without-using-full-screen This guide provides instructions on how to set your PowerPoint (for Windows) application to play your slide show in a window, not in full screen. This is particularly useful if you are participating in a video call and might want to see the presentation, your notes, and the webinar interface.Please note: To display your presenter notes, you will need a two monitor set up.

- Marin-Garcia, J.A., 2022. TFG/TFM cómo citar (en trabajos final de grado o máster). Available at: https://jamg.blogs.upv.es/2022/06/07/3379/ [Accessed June 7, 2022].

- Marin-Garcia, J.A., 2024. Trabajos final de master y grado (TFM-TFG) (II) aspectos adicionales. Available at: https://jamg.blogs.upv.es/2024/06/20/3869/ [Accessed June 20, 2024].

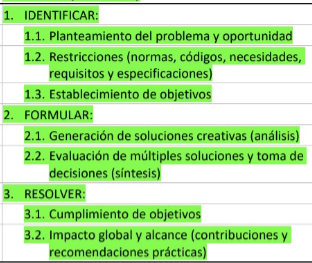

Recientemente (enero 2024) la ETSII ha recomendado que los TFG, al menos tengan estas etapas (que bien podrían ser secciones en el documento):

Este esquema está muy alineado con nuestra propuesta de Triple Diamante. Te recomiendo que leas este documento (lo puedes descargar desde la ruta del DOI) y lo apliques como marco de trabajo para tu TFG.

Marin-Garcia, J. A., Garcia-Sabater, J. J., Garcia-Sabater, J. P., & Maheut, J. (2020). Protocol: Triple Diamond method for problem solving and design thinking. Rubric validation. WPOM-Working Papers on Operations Management, 11(2), 49-68. http://doi.org/10.4995/wpom.v11i2.14776

Y voy a cerrar con otra reflexión, que siendo también obvia, conviene hacer explícita. El Trabajo Final de Grado es responsabilidad del estudiante. Es decir, la gestión del tiempo y los plazos es cosa tuya: cuándo quieres presentarlo, cuánto tiempo vas a dedicar, si tienes las competencias adecuadas para llevar a cabo el proyecto que te interesa, si puedes adquirir esas competencias en el plazo disponible (en el caso de no tenerlas), etc. Obviamente tu director-a está para ayudarte en esas decisiones si le consultas (y si le insistes para que te conteste razonablemente rápido 😉 ). Pero es eso, una ayuda. Te haremos recomendaciones e incluso te calificaremos la nota que creemos que merece y te orientaremos en el caso de que esa nota sea superior a inferior a tus expectativas. Pero las decisiones finales las tienes que tomar tu (pues en el fondo estamos preparando a una persona capaz de actuar como profesional en entornos con complejidad e incertidumbre).

Quizás haya algunos casos donde tu TFG se enmarque dentro de algún proyecto de investigación o convenio con una empresa y tanto los objetivos, como los plazos, como los contenidos te los marque tu director-a o la persona de la que dependas en la empresa. En esas situaciones, la responsabilidad estará compartida entre estudiante y director-a (no me atrevería a decir en qué grado). Pero en todos los demás casos, se debería aplicar lo del párrafo anterior.

Eso significa que habrá momentos donde tendrás que ser autonomo-a. Por ejemplo, si vas a depositar el trabajo al final de un periodo de vacaciones, habrá semanas donde tu director-a no va a poder atenderte y tienes que resolver las cosas por tu cuenta. Eso tiene sus riesgos, porque puedes tomar decisiones que luego perjudiquen el resultado de tu trabajo global. Pero forma parte de la planificación del tiempo (que es responsabilidad del estudiante).

Visitas: 379