En primer lugar, me gustaría aclarar que el impacto de un articulo mucho más que medir sus citas en un determinado proveedor de servicios de indexación de revistas científicas. Lo que pasa es que contar las citas es sencillo (si te conformas con los datos que te proporciona Clarivate/WOS, Scopus o Google Scholar), lo que no quiere decir que sea relevante, ni sea “verdadero” impacto. Es la versión de impacto más sencilla y, a veces, la única que podemos calcular de manera práctica.

Con esto en mente, la pregunta que intentare resolver en esta entrada es ¿cómo saber si un artículo científico publicado es más citado o menos que los artículos similares?

De nuevo tengo que hacer una suposición que no es menos drástica y no genera menos sesgo que la de asumir que impacto = citas. Se trata de asumir que un artículo es similar si:

- Se ha publicado el mismo año. Aunque no es lo mismo que se publique en enero, que en diciembre, o que haya estado años en “advanced online” sin fecha definitiva de publicación… Sobre todo cuando la fecha de publicación es reciente, porque aún teniendo el mismo año de publicación un articulo puede estar expuesto al circuito de citas el doble, triple o incluso cuatro veces más de tiempo que otro (de modo que muy similares no serían)

- Son del mismo “tema” o “área de conocimiento”. La idea de fondo es que hay áreas o comunidades científicas donde los circuitos de maduración de citas (el tiempo habitual que se tarda en ser citado, el numero habitual de citas recibidas y el tiempo que tardas en pasar a ser difícilmente citable por “antiguo”) es muy diferente. El problema es que tanto Clarivate/WOS como Scopus tienen un método un tanto cuestionable (no solo por su poca transparencia, sino por sus patentes fallos de clasificación) de decidir en qué área colocar un articulo y, por lo tanto, establecer el conjunto de artículos similares con el que comparar

Por último, debemos asumir que disponemos de acceso a plataformas de pago que hacen el trabajo por nosotros (no conozco ningún servicio gratuito que permita realizar lo que voy a comentar en esta entrada). O pagas una suscripción a Clarivate/WOS o a Scopus, o la paga la institución para la que trabajas. Pero, al menos con mis conocimientos, esto no lo puedes hacer sin rascarte el bolsillo o que alguien se lo haya rascado por ti (o hayas pirateado o usado materiales al margen de las condiciones de uso exclusivo que permiten Clarivate/WOS o Scopus).

En este contexto, y solo en este contexto, es posible dar algunas respuestas a la pregunta.

Advertencia: el procedimiento, enlaces y pantallazos se corresponden a cómo resolver esto en octubre de 2021. Como las plataformas cambian con relativa frecuencia, es posible que las rutas o ubicación de las opciones sea completamente diferente el día que vayas a intentar hacerlo tu.

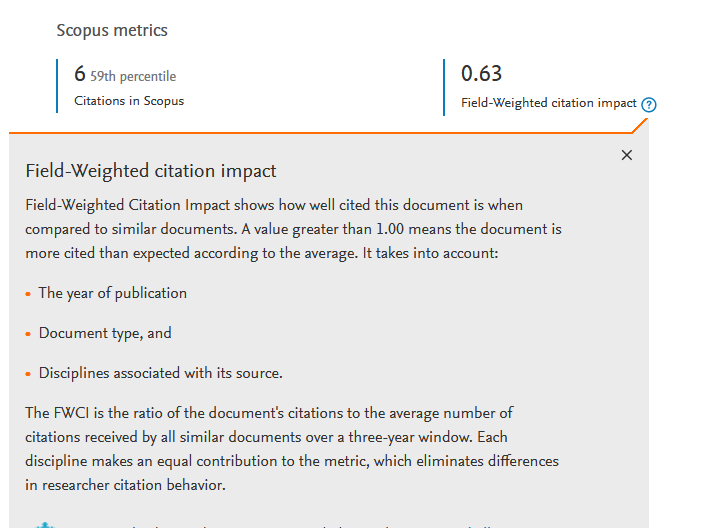

Algunas aclaraciones previas: El FWCI (Field Weight Citation Indez) de SCOPUS es similar al CNCI (Category Normalized Citation Impact) de WOS, el CNCI también lo han “percentilizacion” en el beamplot. Ambos son valores FWCI y CNCI son referente a la media, no son numero de desviaciones estandar respecto a la media, sino cuantas veces las citas de un articulo son respecto a las citas promedio de un articulo equivalente (1 es igual que la media, 2 el doble que la media, 0,5 la mitad que la media). Son valores que van desde 0 a infinito. FWCI y CNCI no suelen coincidir porque el conjunto de artículos que se considera equivalente son claramente distintos. Cada “agencia” agrupa las revistas y los temas de formas distinta y, además ponen parámetros distintos para la agregación y periodo de años.

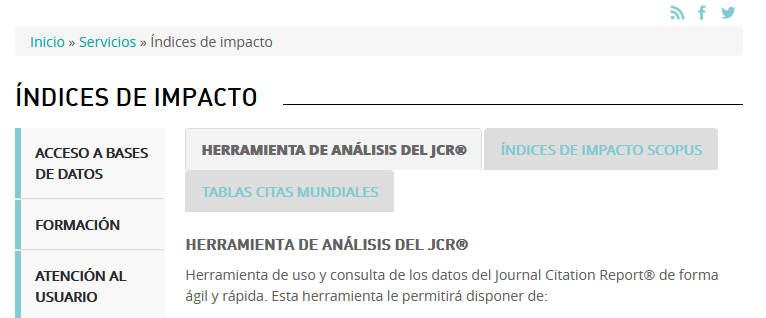

Primera Opción: las herramientas de indices de impacto que proporciona la suscripción de recursos científicos de FECYT

Accedes a la página principal (si no tienes suscripción, no podrás pasar de ese paso): https://www.recursoscientificos.fecyt.es/

y eliges la opción “indices de impacto” en los botones negros grandotes

y en la nueva página eliges el sub-menú “Tablas de citas mundiales” (botón en gris en la parte superior)

En el momento de redactar la entrada si buscas con google “tablas de citas mundiales” los primeros resultados de la búsqueda apuntan directamente a ellas.

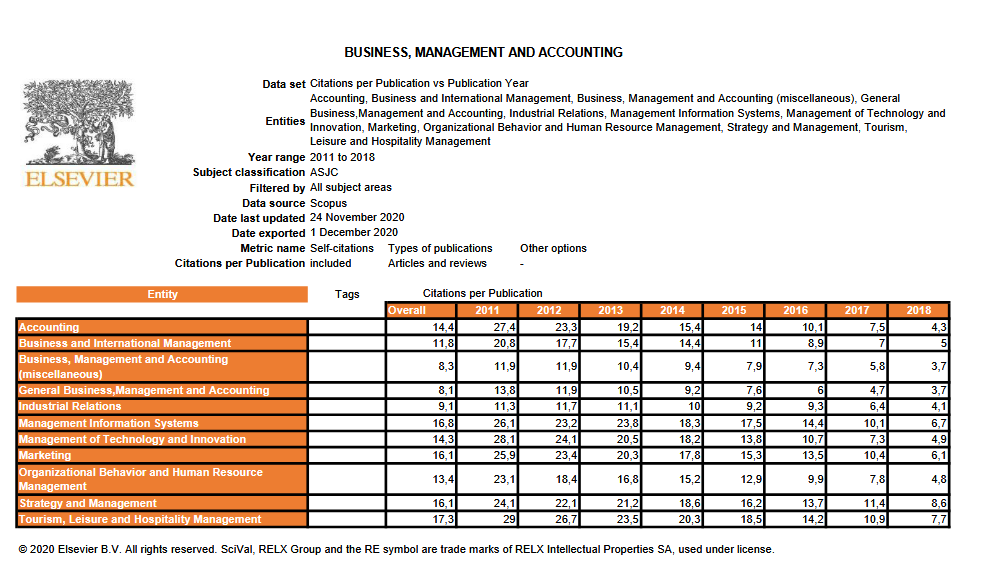

Estas tablas se actualizan una vez al año (sobre noviembre o diciembre) y sólo están disponibles hasta 3 años antes del momento en el que buscas (pues se considera que con menos tiempo, la posibilidad de recibir citas es muy escaso y las tablas no tendrían mucha utilidad, ni fiabilidad). En cualquier caso, si un articulo publicado hace menos de 3 años ya mejora los indicadores de los que aparecían hace 3 años, es muy buena señal de que tiene un “impacto en citas” que se podría considerar excelente (o al menos superior a la media de articulo que llevan mucho mas tiempo en el “expositor”).

Ten en cuenta de que hay tablas para WOS y tablas para Scopus. Porque cada una de ellas se crea con una fuente de datos diferente y con una metodología de agrupación por area temática muy, muy, pero que muy diferente (no te comparas con el mismo conjunto de artículos en WOS que en SCOPUS). Podréis preguntarme “si me salen datos muy diferentes, ¿cual sería el más adecuado para usar en “mi área””. La respuesta sencilla, es: si miras las citas en WOS usa la tabla de WOS y si las miras en Scopus, pues la de Scopus. Pero si lo que te pasa es que cuando comparas WOS te sale muy bien y cuando comparas Scopus te sale muy mal (que tienes menos citas que el promedio), o al revés. Entonces no me atrevo a dar una respuesta más allá del depende. Lo que si es cierto (eso es un dato objetivo) que, la cobertura de revistas del área de ciencias sociales y en especial en los campos relacionados con la administración de empresa (management), a fecha de 2021, es mucho mayor y mejor en Scopus que en WOS. Además, en scopus hay una división mucho más específica por sub-áreas dentro del campo de administración de empresas (Marin-Garcia y Alfalla-Luque, 2018). Pero “hasta aquí puedo leer”. Que haya más cobertura de revistas o más clasificaciones no quiere decir que las agrupe mejor (quizás las agrupe igual de mal que WOS). Resolver esto daría para un artículo científico (animo a quien quiera a que lo haga y si no sabéis a qué revisa mandarlo, en JIEM o en WPOM estaríamos encantados de poder evaluarlo).

Además en cada una de las dos situaciones anteriores tienes dos tablas. En la primera tienes los “descriptivos” de las citas promedio recibidas por los artículos científicos publicados en determinados años, en cada área. En la segunda, para calcular el promedio se han incorporado también “conference proceedings“. Yo, personalmente, creo que solo tiene sentido la primera… pero si alguien se ha tomado la molestia de hacer dos tablas por algo será (como decía “La Bombi” en los casposos años del 1-2-3).

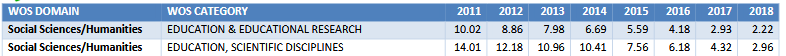

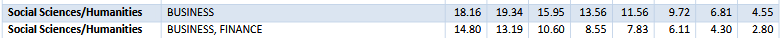

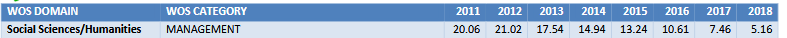

Esta es la información que proporcionan las tablas de citas. Tangase en cuenta que Dirección de Operaciones (Operations Management) no existe como campo, de modo que supongo que hay que considerar los “miscellaneous de business” o business en general como área de comparación. Pero oye, igual a otras personas les parece mejor otra cosa

Segunda Opción: las métricas a nivel de articulo que proporcionan WOS o Scopus

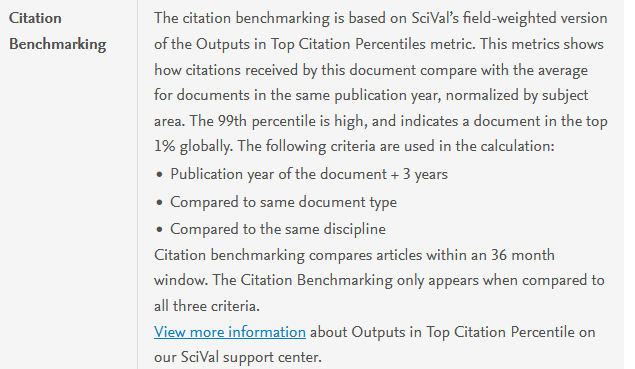

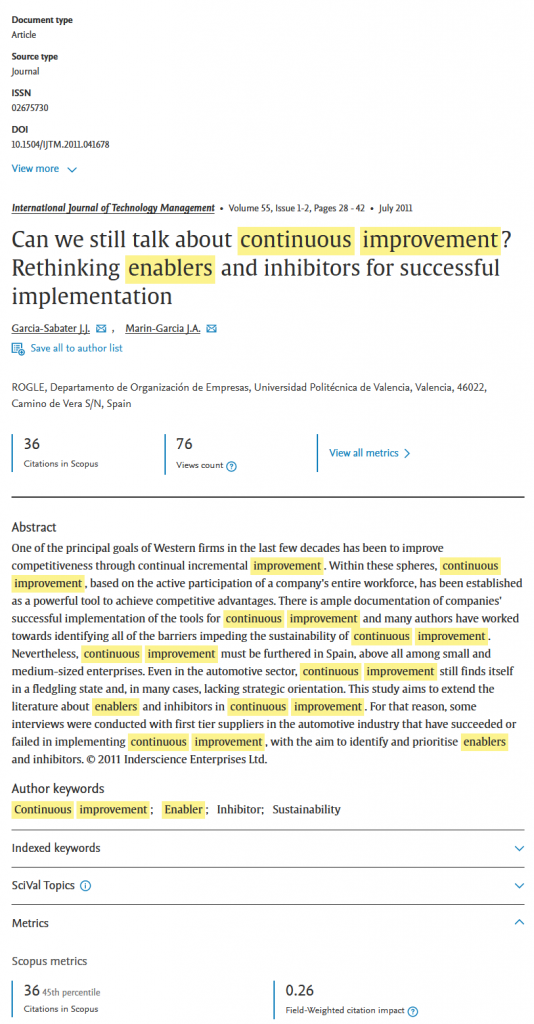

Scopus lleva años (al menos desde 2018) publicando el “citation benchmarking” y el “field-weighted citation impact” , que se definen y calculan como se muestra en la figura (si quieres más información: Learn more about Article metrics in Scopus).

Esta información aparece en la página del articulo (cuando pinchas sobre el título del artículo en los resultados de una búsqueda para que te muestre la información completa). Hace un tiempo era en la parte lateral derecha, ahora está en la parte inferior de la páginas después del resumen… dentro de un tiempo estará en otro sitio.

Junto con el Field-Weighted citation impact (recordad, 1 es que está mas citado de lo esperado) se puede ver el Citation Benchmarking: percentil correspondiente al número de citas del articulo cuando se compara con todos los articulos de scopus publicados en la misma fecha. En la figura, 6 citas en 2016 significa estar en el percentil 59%, lo que puede considerarse un impacto en citas notable dentro de Scopus.

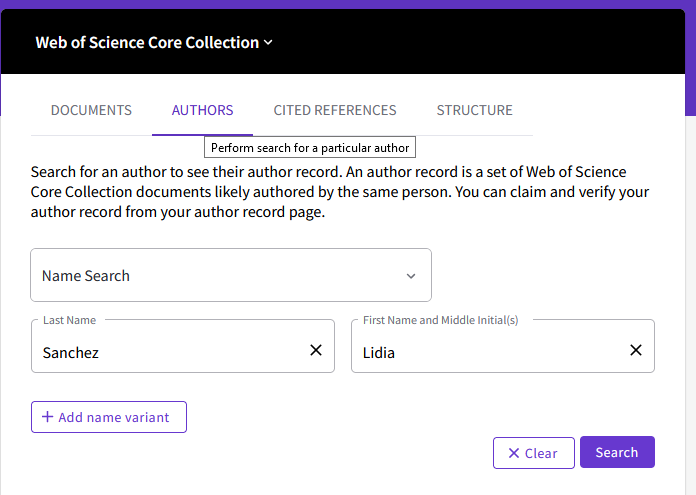

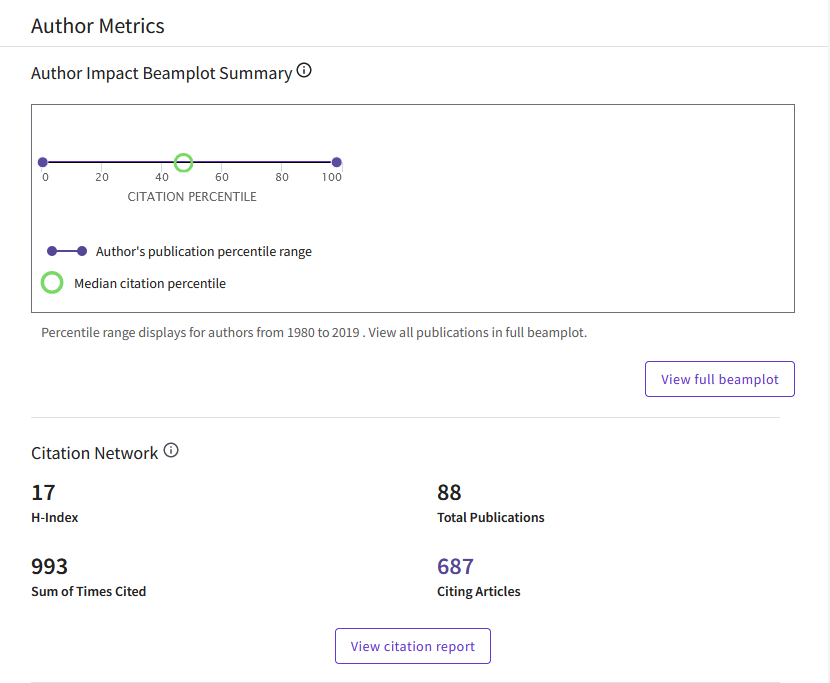

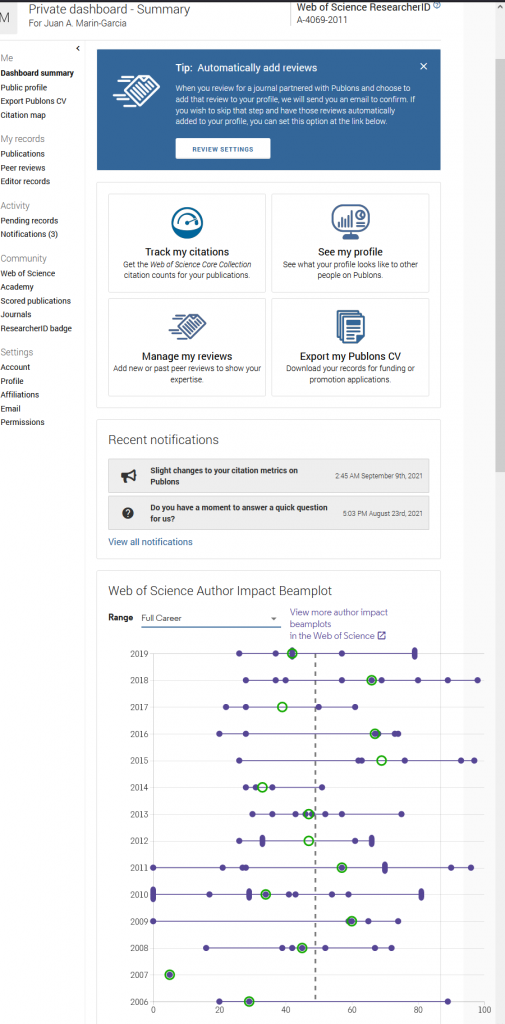

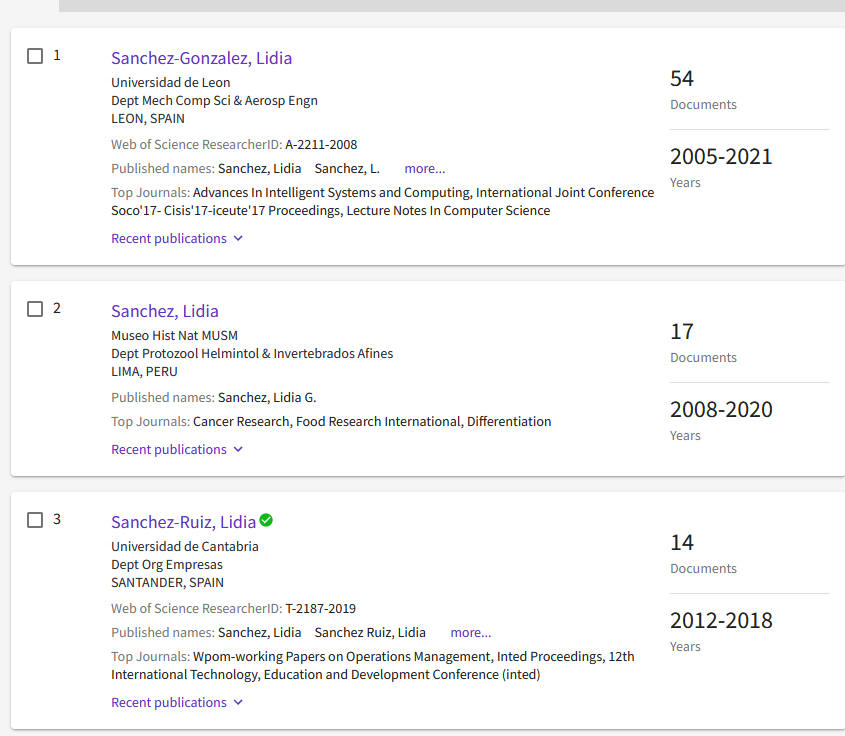

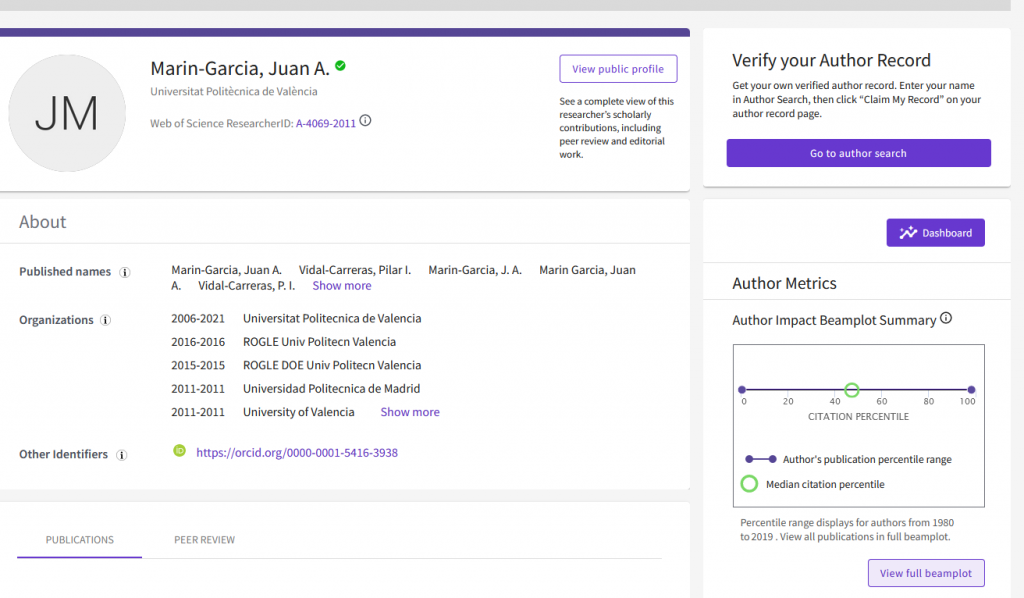

WOS se ha incorporado recientemente (2020) a las métricas a nivel de articulo con su “beamplot“. En estos momentos para acceder a estas métricas debes entrar en la página “personal” de cada investigador (Author Profile). Es decir, que no ves esta métrica cuando entras en la información del artículo. Tienes que localizar primero al autor-a

y luego pinchas en el vínculo que hay en su nombre

y en la página que se abre con el perfil del autor, te desplazas hacia abajo hasta que encuentres el “Author Impact Beamplot Summary) (insisto, ahora está en la parte de abajo de la página, tras todas las citas de lo publicado. Pero pueden colocarlo en cualquier otro sitio en el futuro). Para ver los detalles, pulsa el botón “View full beamplot”

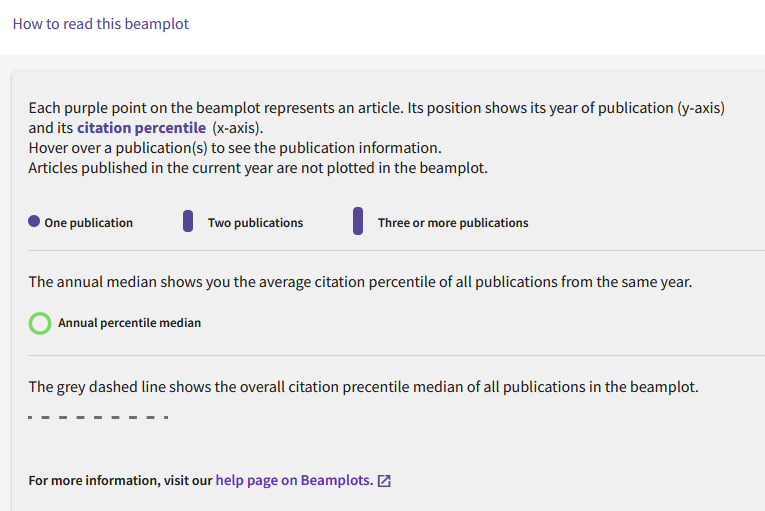

Los datos que se presentan son los mejores percentiles de citas de cada articulo comparando con artículos similares (si está en varias categorías se muestra el mejor). Más información en http://webofscience.help.clarivate.com/en-us/Content/author-record.html#Web

(solo se incluyen artículos del tipo “article” o “review” data papers u otras contribuciones científicas son ignoradas, de momento, en el “beamplot”.

Una forma más rápida puede ser velo desde la cuenta de Publons (si te has creado una cuenta de estas. Es un producto derivado de WOS que promocionaron mucho hace dos años)

Resolvamos un caso práctico

¿Qué posición respecto a impacto en citas tendría este artículo?

Garcia-Sabater, J. J., & Marin-Garcia, J. A. (2011). Can we still talk about continuous improvement? Rethinking enablers and inhibitors for successful implementation. International Journal of Technology Management, 55(1/2), 28-42.

(datos recogidos el 29 de septimbre de 2021)

Opción 1:

36 citas Scopus; 36 citas en WOS

El artículo es de 2011, y la temática es de dirección de operaciones, de modo que voy a la tabla de citas de Scopus en la categoría de miscelánea dentro de Business y management, el promedio de citas para artículos de ese año son 13,8. Como el articulo tiene 36 es citado más del doble que el promedio. Si voy a la de WOS en Business es 18.16 y en management es 20,6, de nuevo 30 citas en WOS es casi el doble que el promedio de artículos de ese año en la categoría.

Opción 2:

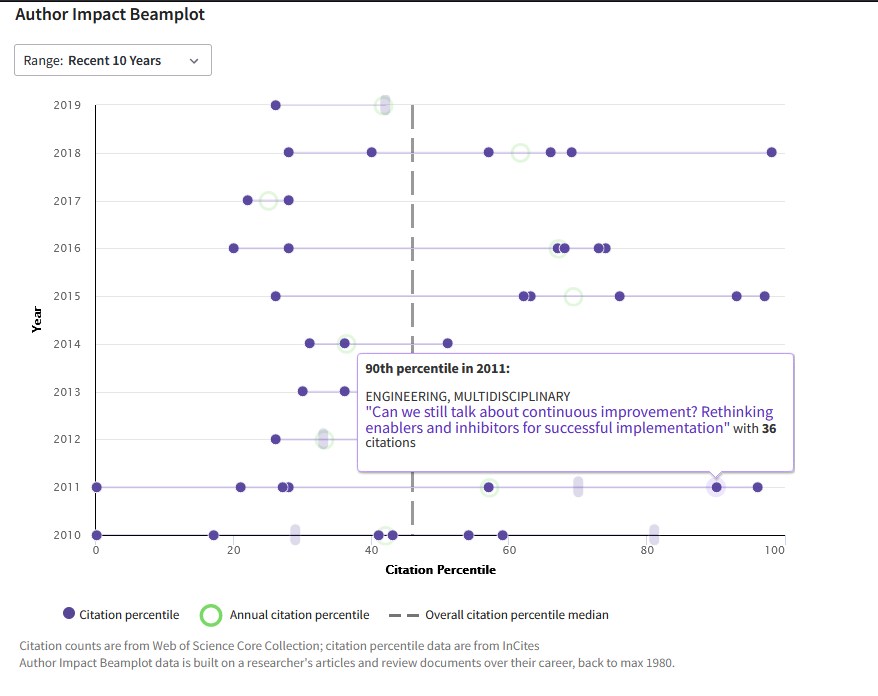

WOS Beamplot: Busco el perfil de uno de los autores (en este caso el segundo autor), Me desplazo hasta la parte de la página donde esté el gráfico “beamplot” y pulsa el botón “view full beamplot”

y si paso el ratón por encima de uno de los artículos puedo ver los detalles. En este caso voy pasando por todos los de 2011 hasta encontrar el que me interesa. 36 citas en WOS para éste lo sitúa en el percentil 90

Scopus FWCI: busco el artículo en Scopus. En la pagina de detalle abro el campo de “metrics” y las 36 citas para un articulo de 2011 indica un percentil 45% y el FWCI es de 0.26 (que está alejado de 1).

Puede llamar la atención la diferencia de resultados (sobre todo cuando se compara con la tabla de citas de Scopus, que es la misma fuente de datos). Pero no olvidemos que:

The FWCI is the ratio of the document’s citations to the average number of citations received by all similar documents over a three-year window

Seguramente el FWCI no es un buen indicador para articulos antiguos (que seguramente ya no se citan en los últimos tres años, que parece que es la ventana que consideran).

Referencias:

- Marin-Garcia, J. A., & Alfalla-Luque, R. (2018). Protocol: Is there agreement or disagreement between the absolute and relative impact indices obtained from the Web of Science and Scopus data? WPOM-Working Papers on Operations Management, Vol 9(1), 53-80. https://doi.org/10.4995/wpom.v9i1.8989

- Garcia-Sabater, J. J., & Marin-Garcia, J. A. (2011). Can we still talk about continuous improvement? Rethinking enablers and inhibitors for successful implementation. International Journal of Technology Management, 55(1/2), 28-42.

Visitas: 2097