Extended Title: Action research on designing materials, protocol, and feasibility of a complex intervention to foster critical thinking and apply the triple diamond framework in group decision-making.

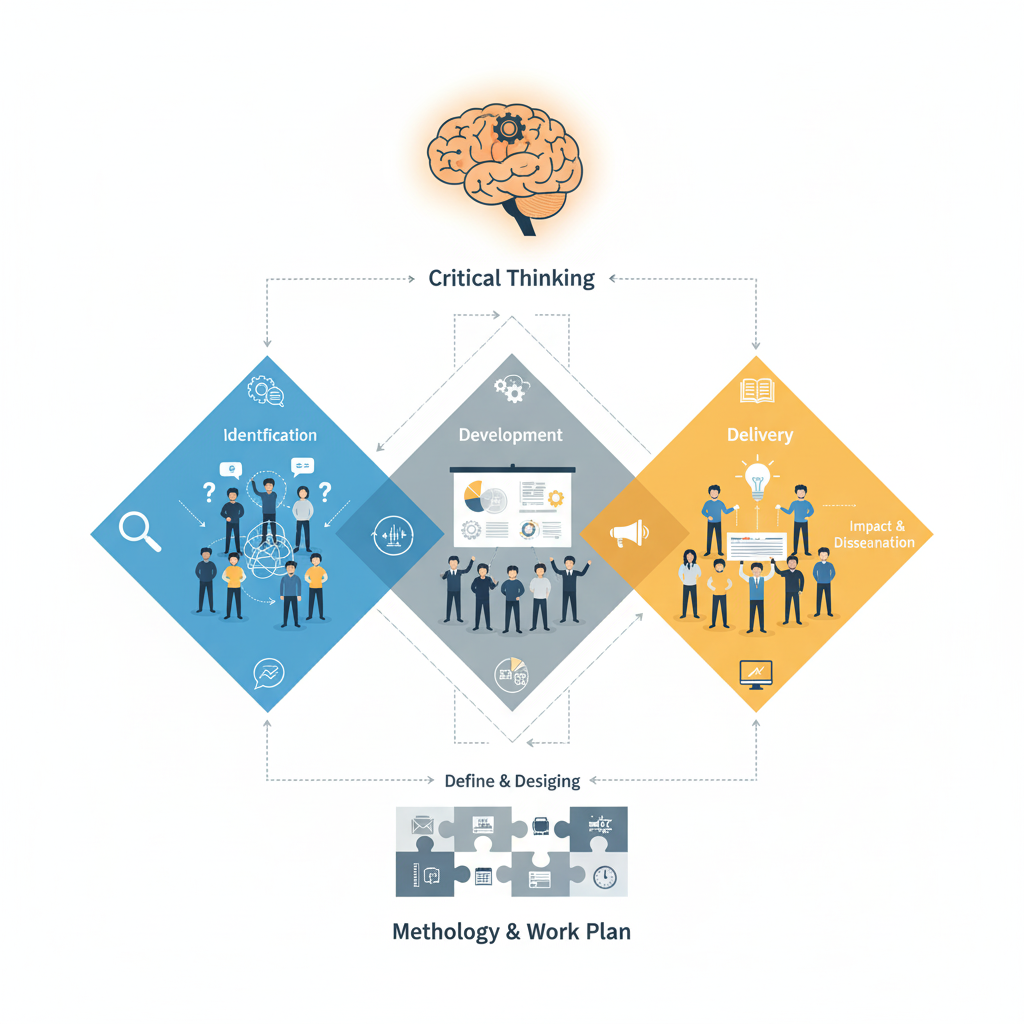

This project aims to enhance students’ critical thinking and decision-making skills by developing, testing, and refining a structured group decision-making framework called the triple diamond. It focuses on identifying misconceptions that hinder students’ use of this framework and improving pedagogical interventions through active, collaborative learning and evidence-based methodologies.

- Project scope and participants: The innovation will be implemented across multiple courses in engineering, logistics, and business master’s programs, involving diverse student groups facing recurring difficulties in applying structured decision-making methods.

- Problem identification: Students consistently rely on intuitive rather than structured approaches in group decisions, struggling to apply the triple diamond framework despite repeated instruction and practice. This issue is persistent and mirrors challenges observed in professional settings.

- Theoretical foundations: The project integrates concepts of misconceptions, knowledge elicitation, threshold concepts, and decoding the discipline to reveal and address barriers to expert-like thinking in decision processes. It emphasizes the reorganization of knowledge fragments rather than the mere replacement of incorrect ideas.

- Learning objectives: Students will learn to manage group decision processes using the triple diamond, define tasks and prioritization criteria explicitly, analyze innovation competencies, and develop reasoned, evidence-based reports, all enhancing critical thinking skills.

- Methodology: The project employs active and collaborative learning through structured three-hour classroom dynamics complemented by autonomous preparatory work. It incorporates innovative visual case representations, reflective learning journals, and think-aloud protocols to elicit student thinking and identify misconceptions.

- Expected outcomes: These include identifying common misconceptions, adapting and developing rubrics for assessment, quantifying students’ valuation of innovation competencies, improving decision quality and reducing cognitive biases, and evaluating the impact of different case presentation formats on engagement and critical thinking.

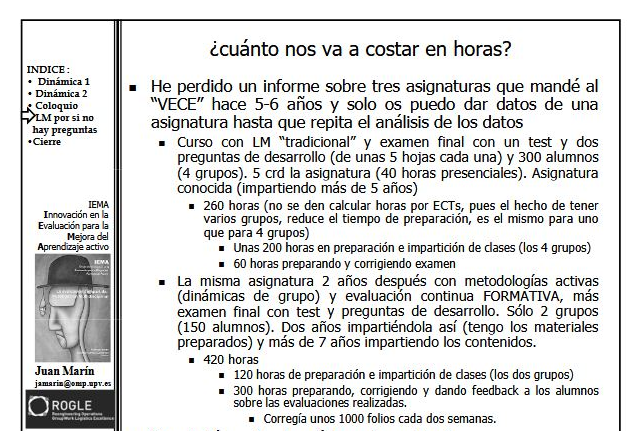

- Work plan and tools: The two-year plan details tasks such as material development, rubric adaptation, protocol design, experimental validation, and dissemination through academic articles and conferences. Project management uses O365 tools with regular team meetings and quality control processes.

- Evaluation strategy: Evaluation includes measuring the number and categorization of misconceptions, rubric validation, analysis of student preferences and clusters, transferability assessments, pre-post intervention comparisons, and engagement metrics using established models. Data collection involves think-aloud sessions, forum analyses, and observations.

- Impact and dissemination: The project aims to improve teaching and learning by making decision-making processes transparent and evidence-based, enabling transfer across disciplines and formats, including MOOCs. Results will be shared via conferences, indexed publications, online platforms, and social media, ensuring broad accessibility and adoption.

#PI-DECIDE

Visitas: 27