I will be presenting this research at the upcoming XVII International Workshop ACEDEDOT – OMTECH 2026, taking place in Almería, Spain, from March 12-14, 2026:

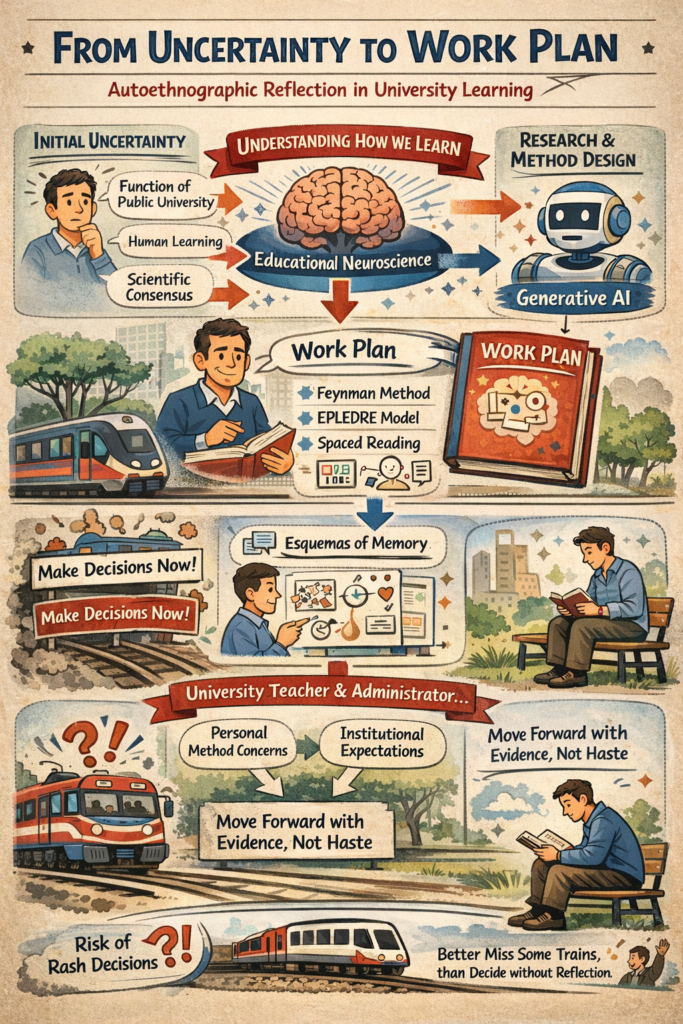

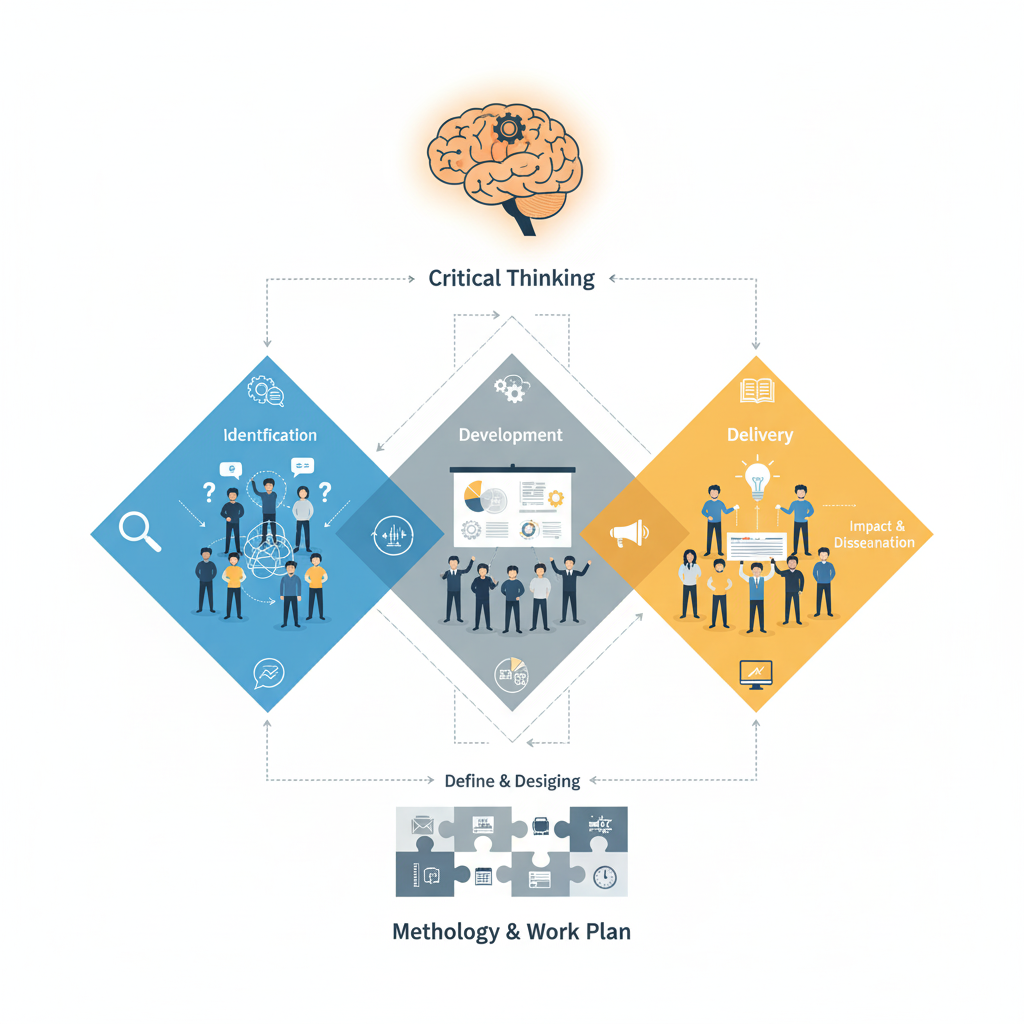

This communication presents an autoethnographic reflection. Building on four fundamental premises about the function of Spanish public universities and the established mechanisms of human learning, the author documents his personal journey from initial uncertainty to the design of a systematic work plan. The study focuses on understanding the current scientific consensus on how learning is consolidated in the brain and exploring the possibilities of generative AI to enhance this process in the university context. Drawing on the work of Héctor Ruiz Martín, a work plan is designed that combines recommendations from educational neuroscience with the Feynman method and the EPLEDRE model, including spaced reading, creation of sketchnote-type graphic schemes from memory, and public communication of the knowledge constructed. The communication shares the first graphic schemes developed and reflects on the author’s dual position as university teacher and administrator, facing both his own methodological uncertainties and institutional expectations for strategic guidance. It questions the “collective panic” surrounding the emergence of generative AI in universities and the pressure to make quick decisions without sufficient reflection. It proposes replacing reactive urgency with a deliberate process of calm, evidence-based reflection and pilot experimentation, recognizing that in contexts of accelerated change, it is preferable to miss some “trains” rather than make biased decisions under collective amygdala hijacking

Keywords: Learning; autoethnography; generative artificial intelligence; university learning; educational neuroscience; teaching transformation

Visitas: 28