El otro día me enteré de que hay empresas que subcontratan por completo sus memorias de sostenibilidad a consultoras externas. Y no me refiero a buscar apoyo técnico o asesoramiento, sino a delegar absolutamente todo el proceso. Esto me hizo reflexionar sobre un patrón que ya he visto repetirse con mucha frecuencia.

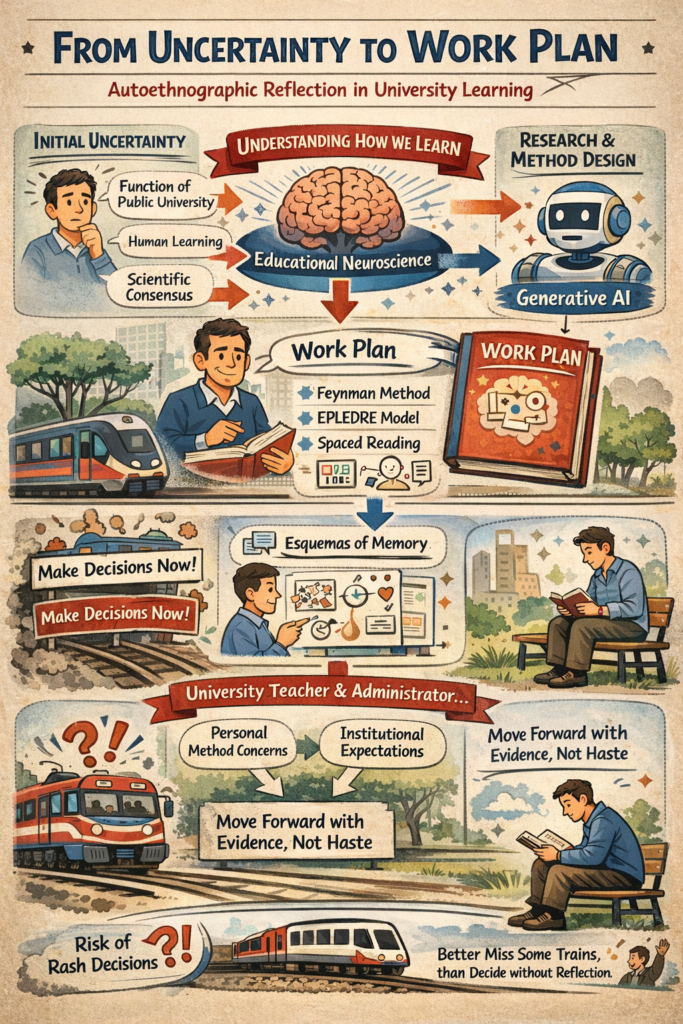

La lógica inicial es aparentemente sólida: cuando surge una nueva normativa que obliga a elaborar memorias sobre cualquier tema relevante (sostenibilidad, igualdad, transparencia, gestión de títulaciones, etc.), la idea detrás de la normativa es estimular la reflexión. El ejercicio de analizar qué hacemos, por qué lo hacemos y cómo podríamos hacerlo mejor debería ser una oportunidad de crecimiento y mejora continua. Sin embargo, cuando estas normativas llegan impuestas desde arriba, muchas organizaciones no las perciben como una oportunidad, sino como una carga burocrática, algo que etiquetan como No-Valor-Añadido-No-Evitable.

¿Cómo funciona la cadena de la externalización? Pues la verdad es que con un proceso bastante absurdo: la empresa contrata a una consultora (o un becario-a) para que busque los datos (o los invente, da igual), elabore un análisis con esos datos y redacte una memoria que cumpla con todos los requisitos legales. El objetivo no es aprender ni mejorar, sino simplemente evitar problemas regulatorios. La empresa que contrata ni siquiera lee el documento final.

Ahora estas consultoras (o estos becarios) están delegando todo el proceso (o toda la parte que pueden) a herramientas de inteligencia artificial generativa. El resultado es una farsa perfectamente orquestada: la empresa presenta memorias impecables, con una calidad de redacción como jamás había conseguido y un número impresionante de páginas. Los organismos auditores están satisfechos porque reciben más memorias que nunca, creyendo que están cumpliendo su misión de velar por la mejora en su área de responsabilidad.

Sin embargo, en todo este proceso no hay ni una sola neurona dedicada a pensar realmente en cómo mejorar o dónde pueden estar los problemas. La rueda sigue girando, pero ahora con muchas más personas implicadas, más gasto de energía y más dinero invertido en una actividad que ha perdido completamente su propósito original.

Mi Estrategia Personal

Frente a este panorama, he decidido adoptar una estrategia diferente. Voy a centrarme en encontrar usos para la IA generativa que me ayuden a aprender, a crecer intelectualmente y a explorar territorios que antes estaban fuera de mi alcance. Aprovecharé que la IA aún es relativamente barata porque las empresas necesitan nuestros datos para seguir entrenando sus modelos. Cuando se me acabe este chollo tecnológico, volveré tranquilamente a leer libros (o, dependiendo de la edad a la que me pille, a jugar a la petanca).

Si, además, consigo contagiar a alguien más para que use estas herramientas de manera inteligente, genial. Si no lo logro, tampoco me agobia. Lo importante es que yo voy a aprovechar esta oportunidad mientras dure.

Todo esto me recuerda a las clases de educación física en el colegio. A mí me encantaba dar vueltas al campo porque disfrutaba haciendo ejercicio. Algunos compañeros se escondían detrás de un árbol y aparecían solo en la última vuelta para que el profesor los viera llegar. Yo me lo pasaba muy bien corriendo, ellos se lo pasaban muy bien escondiéndose. Cada uno disfrutaba de la opción que había elegido. Nunca me importó que otros se escondieran (es más, me dejaban la pista más libre para correr a mi ritmo). Me habría fastidiado tener que esconderme y perder el tiempo en lugar de dar tres vueltas más al campo, pero nadie me impidió correr. Ahora creo que la situación es similar: puedo elegir cómo relacionarme con estas nuevas herramientas, independientemente de lo que hagan los demás.

Vivimos en una época en la que es fácil dejarse arrastrar por la corriente del mínimo esfuerzo y la externalización de todo lo que requiere pensamiento crítico. Pero también tenemos la oportunidad de usar estas mismas herramientas que otros emplean para evitar pensar, precisamente para pensar mejor y llegar más lejos. La elección, al final, es nuestra.

El problema no está en la tecnología en sí, sino en cómo decidimos relacionarnos con ella. Podemos usarla como una muleta para evitar el esfuerzo intelectual o como una palanca para amplificar nuestras capacidades de reflexión y aprendizaje. Yo tengo claro qué opción elijo.

Visitas: 36